L’annunciata partecipazione di Papa Francesco il prossimo giugno alla sessione del G7 sull’intelligenza artificiale (IA), aperta agli Stati non membri del vertice, apre nuovi orizzonti di riflessione sugli aspetti etici del potere computazionale. Riprendendo Paolo Benanti, “l’attenzione al grande mondo dell’IA che stanno mostrando i governi e le organizzazioni internazionali è espressione di questa consapevolezza: capacità computazionale e algoritmi sono oggi le nuove facce del potere.”

Alcuni interrogativi si pongono anche sul piano della partecipazione libera e democratica nell’espressione del voto. Circa 359 milioni di elettori europei, nei 27 Stati membri, sono chiamati alle urne per rinnovare il Parlamento europeo tra i 6 e 9 giugno 2024. Il 2024 è l’anno in cui votano ben 76 Paesi, il 51% della popolazione mondiale.

Possiamo parlare di democrazia computazionale? Quali possibili condizionamenti? Sussiste il rischio che possa ripetersi, seppur in altre modalità, la vicenda Cambridge Analytica? Quali tutele per evitare profilazione e persuasione di massa?

Emblematica la vicenda Cambridge Analytica. La società, poi sciolta nel 2018, partecipò attivamente alle elezioni presidenziali negli Stati Uniti nel 2016. Furono utilizzati i dati Facebook di milioni di cittadini ricorrendo alla tecnica del microtargeting per disegnare un vero e proprio modello di persuasione. Furono definiti i profili psicometrici e comportamentali degli utenti. Emozioni, attitudini, inclinazioni, convinzioni e pregiudizi tradotti in termini numerici e quantitativi segmentando la popolazione in gruppi omogenei per comportamento, interessi personali, preferenze. Vale a dire, deducendo informazioni personali dall’attività online. Maggiori informazioni disponibili, quindi maggiori dati, per l’analisi automatica con algoritmi di machine learning significano una più dettagliata profilazione.

“L’uso di targeting psicologico permette di influenzare il comportamento di grandi gruppi di persone, adattando messaggi persuasivi ai bisogni psicologici del pubblico a cui ci si rivolge”, sottolinea Nello Cristianini – docente di IA all’Università di Barth nel Regno Unito.

Partendo, ad esempio, dai “mi piace” sui social è possibile ricavare preferenze e tipi di personalità. Applicando la tecnica psicometrica in ambito politico, gli elettori sono raggiunti da messaggi creati di proposito per riflettere le rispettive caratteristiche. I destinatari saranno rafforzati nelle opinioni e nei posizionamenti. Oppure, qualora identificati come elettori indecisi, il messaggio sarà confezionato per indurre un cambiamento. Insomma, profilazione dei cittadini per opinioni politiche, gruppi sociali, etnici, religiosi o culturali. Raggiunti da una comunicazione politica intrusiva e mirata che allinea i destinatari (cittadini) con gli obiettivi dell’agente.

Dal microtargeting politico emerge il rilevante tema della profilazione e della predittività in rapporto alla democrazia. Ovvero, quale spazio per l’espressione di una libera espressione di voto? L’uso strumentale di profilazione e IA può modificare l’IA predittiva in prescrittiva?

Con la predittività si determinano le probabilità di comportamenti o eventi, singoli o collettivi, che si potranno verificare. La domanda è: che cosa potrebbe accadere? Il risultato è una previsione. Con la prescrittività si determina il comportamento. La domanda è: che cosa devo fare? Il risultato è, appunto, una prescrizione. Risulta evidente che posizionando la predittività, sulla base della profilazione di gruppi di cittadini, verso un obiettivo predeterminato si orienta anche la prescrittività. Obiettivo finale è la persuasione di singoli o di gruppi che fanno propri orientamenti preordinati.

Si creano bolle informative. Si isolano gli individui in camere di eco (echo chambers) che rafforzano convinzioni preesistenti salvo manipolarle anche in senso contrario. Vale a dire una polarizzazione del voto e a un deterioramento del dibattito pubblico.

La democrazia si fonda sul principio che la partecipazione sia libera con il presupposto che ci sia un flusso aperto e libero di informazioni. Che si possa sviluppare la capacità di elaborare le informazioni in modo consapevole. Certo non è ragionevole accantonare le innovazioni tecnologiche in una sfera aprioristica di contrarietà. Non ha senso un neo-luddismo. Né ragionevole contrapporre tecnofili vs tecnofobi, tecnoconservatori vs tecnoprogressisti.

Piuttosto è necessario coniugare innovazione tecnologica e un’etica degli algoritmi (algoretica) umanocentrica. Confrontando la “democrazia computazionale” con i fondamentali della Dottrina sociale della Chiesa.

Trasparenza e responsabilità rappresentano gli end point, i principi etico-sociali tra quelli fondamentali. Ad esempio, il problema della trasparenza degli algoritmi è tra i più problematici e discussi. Molti sistemi di IA sono “scatole nere” (black box) con opachi processi decisionali. Senza una comprensione di come l’IA arriva alle sue conclusioni, è pressoché impossibile valutare l’attendibilità delle informazioni fornite. Così la responsabilità è un aspetto altrettanto critico. Quando l’IA predittiva viene utilizzata in contesti democratici, è essenziale che ci siano meccanismi per assicurare che gli algoritmi non producano discriminazioni e violazione di diritti civili.

È necessaria l’attuazione del principio di esplicabilità (explicability)che può fornire chiarimenti sulle cause delle decisioni (output), i meccanismi di elaborazione e l’interpretazione dei dati. Consente di valutare appropriatezza o inadeguatezza dei risultati prodotti. A sua volta, il principio di esplicabilità comprende quello epistemologico di intellegibilità (intelligibility) che risponde alla domanda: come funziona? e quello etico di responsabilità (accountability) che a sua volta risponde all’interrogativo: chi è responsabile nel modo in cui funziona?

Su questa linea il Parlamento europeo ha approvato l’EU Artificial Intelligence Act (AI Act) per regolamentare lo sviluppo e l’utilizzo. Per tutelare i diritti, salvaguardare la democrazia senza però frenare l’innovazione. Vietando o limitando l’uso di sistemi di IA che presentano un rischio inaccettabile per la sicurezza, la dignità o l’autonomia delle persone, o che violano i valori democratici.

A livello italiano, in questi giorni è stato presentato dal Governo un DdL che mira alla regolamentazione dell’IA sul base del rispetto dei diritti fondamentali e delle libertà dell’ordinamento italiano ed europeo oltre che sui principi di trasparenza, proporzionalità, sicurezza, valorizzazione anche economica del dato, protezione dei dati personali, riservatezza, robustezza, accuratezza, non discriminazione, parità dei sessi e sostenibilità. Inoltre, si specificano i principi che caratterizzano lo sviluppo e soprattutto la concreta applicazione nel rispetto dell’autonomia e del potere decisionale dell’uomo, della prevenzione del danno, della conoscibilità, della spiegabilità. Si stabilisce che l’utilizzo dell’IA non deve pregiudicarela vita democratica del Paese e delle istituzioni. Un dato molto importante è che ci si prefigge di garantire alle persone con disabilità il pieno accesso ai sistemi di IA senza forme di discriminazione.

Tenendo conto che le innovazioni legate all’IA hanno uno sviluppo e una diffusone globale, abbiamo risolto gli interrogativi che ci siamo posti? Che cosa faranno altri Paesi che non fanno parte dell’Unione Europea?

Ecco altri, sostanziali e non secondari interrogativi inerenti al rapporto tra tecnocrazia e democrazia a livello globale. I sistemi di IA non hanno un perimetro geografico definito. Le reti neurali artificiali (Artificial Neural Network o Simulated Neural Network) sono pressoché ubiquitarie. Non conoscono confini.

Ecco l’attualità dell’esortazione di Fabio De Felice e Roberto Race nel saggio “Il mondo nuovissimo”. “La risposta agli interrogativi è che solo governando questi processi e non rincorrendo la tecnologia possiamo immaginare di regolare i rapporti tra big tech e le istituzioni di governo, senza più propalare una parvenza simulatrice di libertà, ma promuovendo una libertà vera, regolamentata con strumenti condivisi.”

Un ragionevole obiettivo su cui costruire un dialogo legittimato dai fondamentali della democrazia. Si richiede un impegno comunitario per evitare il paternalismo sociale degli algoritmi. Ovvero l’algocrazia, il nuovo decisore sociale, il Leviatano dei nostri tempi.

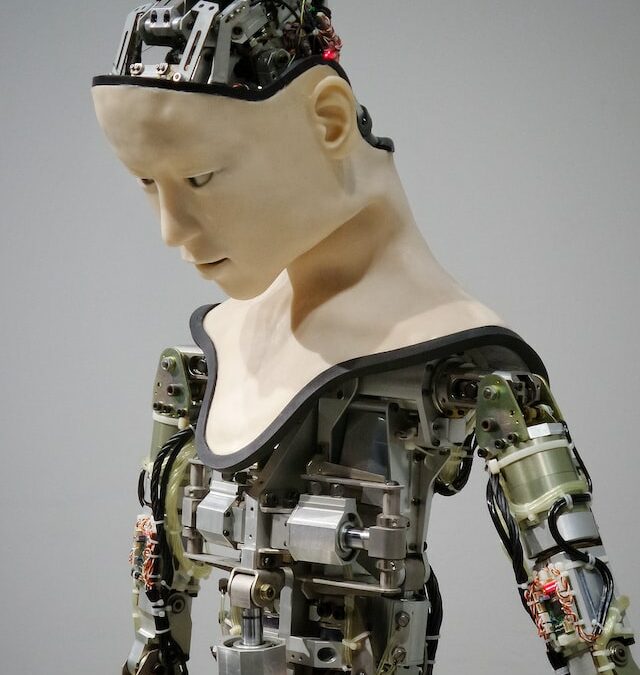

Crediti foto: Possessed Photography su Unsplash